AI

ChatGPTはどうやって文章を作っているのか(超ざっくり)

こんにちは!つつです!

ChatGPT は、人と話しているように自然な文章を返してくれます。

ただ、その仕組みはよく分からないまま使っている方が多いかもしれません。(僕もその1人ですが…)

仕組みを知らなくても使えるように作られているのは、本当にすばらしいです。

ですが少しでも知っておくと、

- 「あれ?思っていた答えと違う」

- 「そういうことじゃないんだよな」

といった場面を減らせるかもしれません。

「ざっくりこういう感じなんだな」と知っておくだけで、使い方は変わるはず!

今回は、ChatGPT がどんな風に文章を作っているのかを、超ざっくりまとめてみました!

大枠はただ次の言葉を予測しているだけだった

大枠の仕組みとしては次に来る言葉をただ予測しているだけです。

流れは大きく分けて3ステップ。

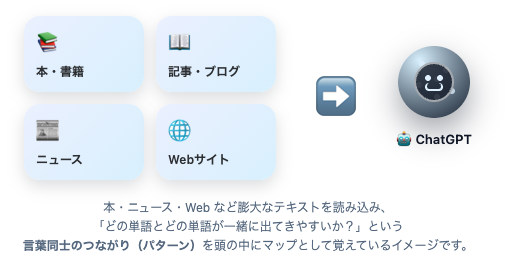

1.大量のデータから「言葉のつながり」を学ぶ

ChatGPTは、学習の段階で

公開されたテキストや、ライセンスされたデータ、人間が用意したデータなど、膨大な文章データから学習しています。

例)

本・ニュース・ウェブサイト・会話データ・プログラムコードなど

- この文脈のあとは、どんな表現が続きやすい?

- どんな質問には、どんな答えの形が一般的?

- 自然な文章の流れって?

といった 言語の統計的パターン を習得します。

🔍 厳密には

- ChatGPTが扱うのは「単語」ではなく

テキストを細かく分割した トークン(Token)

※サブワードや記号など、意味的に中途半端な断片も含む - 学習後には 人間のフィードバック(RLHF) によって

“より人が好む・安全な応答” へ 追加調整 されています

💡イメージ

ChatGPTがしているのは

「意味理解」というより

「こう続きやすい」という

統計的な関連性の学習

意味を理解しているというよりは、このトークンの次はこのトークンがよく続いているというような、

パターンを学習しているイメージ

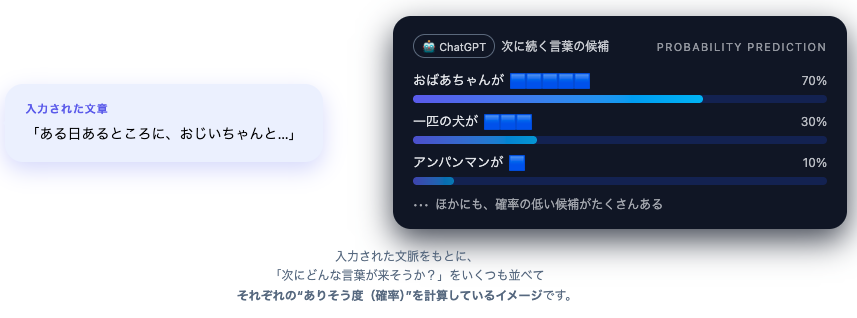

2.「次に来るトークンの確率」を予測する

学習が終わったモデルは、入力文を読んだうえで

次にどのトークンが来る確率が高いかな?

を高速で計算します。

例)

「ある日あるところに、おじいちゃんと・・・」

候補の言葉 | 予測された確率 |

|---|---|

おばあちゃんが | 0.7 |

アンパンマンが | 0.1 |

一匹の犬が | 0.2 |

その他いろいろ | … |

この 確率の予測 を実現しているのが

「Transformer(トランスフォーマー)」という仕組みです。

🔎Transformer は、文章内の関係を理解して、最適なトークンを選び出す仕組み!

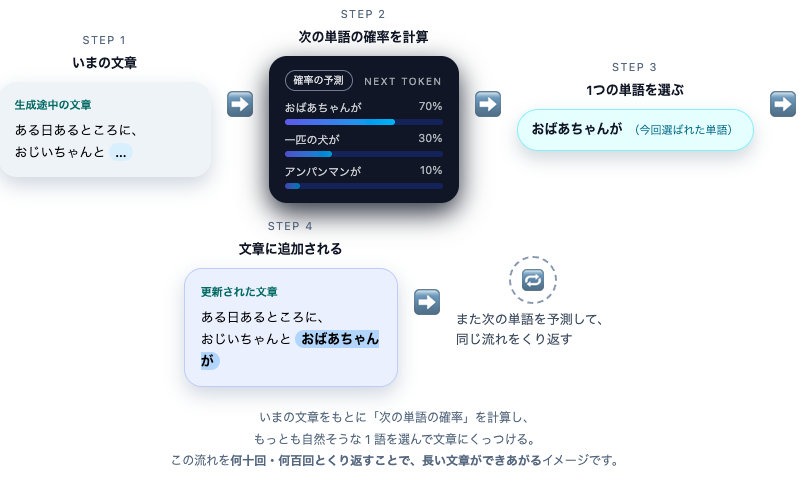

3.確率が高いものを選び続けて文章ができる

あとは、

- 次のトークンの確率分布を計算

- 高い確率(+少しランダム性)で1つ選ぶ

- 文章に追加

- また次を予測…

という流れを 1トークンずつ 繰り返すだけ!

これだけで、私たちが見ているような

なめらかな文章が出来上がります。

本当にこれだけであんな自然な文章ができるのか!?

と思うほどシンプルですが、

大枠の原理は

“ただ、ひたすら次にくるトークンを予測“

しているだけです。

ChatGPTというサービス全体では、

安全フィルタやツール利用なども組み合わさっているが、

言語モデルのコアな仕組みは『次のトークン予測』である

より良い回答を得るための伝え方(超基本)

ChatGPTは今までの文脈から

“次に続きそうなトークン”を選び続けているだけ

だということがわかったと思います。

ですので文脈(前提や背景)を足してあげることが超重要です。

例①:旅行プランを聞くとき

まずは文脈が少ないとどうなるか?

❌「週末におすすめの旅行プラン教えて」

→ 行き先も予算も、誰と行くのかも分からないので

ふんわりした一般論になりがち

具体的に伝えると…

⭕「2人で1泊2日の国内旅行。

予算は1人3万円以内。

カフェや景色を楽しむゆったり旅がいい。

移動は少なめで!」

→ 実際に行けそうな現実的なプランが返ってきやすい!

🔍例②:仕事メールを頼むとき

こちらも同じです。

❌「上司にメール書いて」

⭕「上司に企画の承認をお願いしたい。

丁寧なビジネス文書で、

要点は3つにまとめて、件名もつけて」

→ そのまま使える文章になりやすい!

プロンプトに含めるべき前提情報

ChatGPTには次を添えると精度UP

ポイント | 例の内容 |

|---|---|

誰向けに? | 上司へ、友達へ、お客様向けに… |

目的は? | 承認してほしい、提案したい、相談したい |

条件・制約 | 予算、時間、NG要素、文字数 |

出力形式 | 箇条書き、件名付き、見出し付き |

まとめ

ChatGPTは、一見「なんでも答えてくれるすごい存在」に見えますが、その大枠の正体は

- 大量の文章から「トークンのつながり方」を学び

- 次に続きやすいトークンを確率的に選んでいる

という、シンプルな仕組みです。

文脈や前提をちょっとだけ足すと、

「お、わかってんじゃん!」と思える回答に出会えるかも!